音声認識と“環境音も含む音理解”の重要性

まず、音声を認識するためには、マイクから取得した音声データを分析する必要があります。例えば、人が「ねえ、お願い」などと発した声を正しく聞き取り、理解するには「マイクで音を取る →音をデジタルデータにする →分析して意味や指示を得る」という流れがあります。

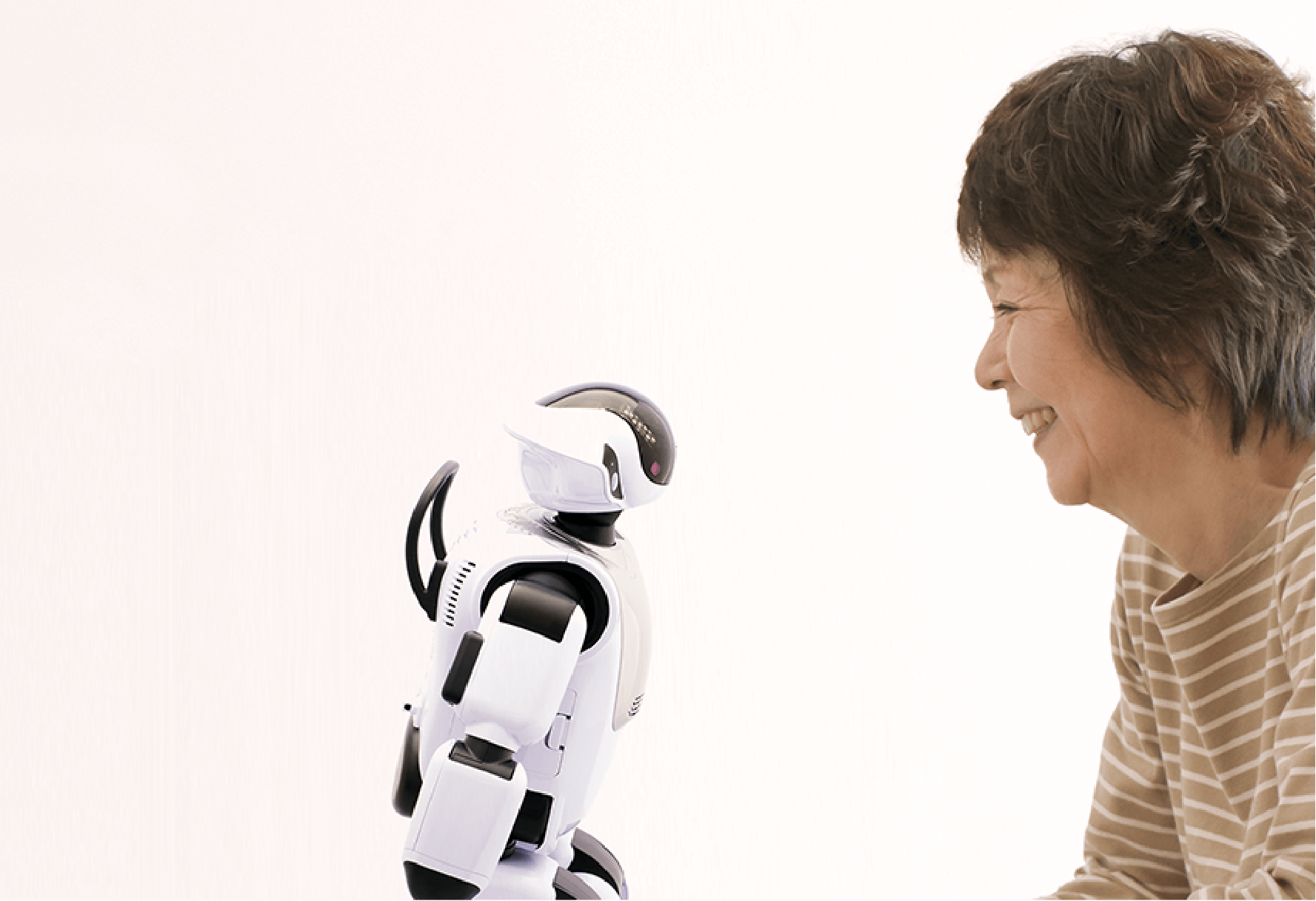

ところが、今後のヒューマノイドロボット(人のような形・動きをするロボット)を考えると、「人間の声を聞き取る能力」だけでは充分とは言えません。静かな環境だけでなく、例えば「小さい声」「騒々しい環境」の中でも人の指示を確実に聞き取ること、そしてさらに「お湯が沸く音」「車のクラクション」「動物の鳴き声」といった非言語的な音も“意味のある情報”として読み取る能力が求められます。

たとえばキッチンでロボットが「お湯が沸いた」ことを察してお茶を準備したり、街中で車のクラクションを認識して注意を促したり、あるいは動物の鳴き声を聞いて“近くに動物がいる”という判断を下したり、といったシーンを想像してください。人間なら無意識に「この音は何だ?」「どこから来た?」「何が起きた?」と解釈をしますが、ロボットにも同様の能力が必要になります。

このように音を「ただ文字や言葉として聞く」だけではなく、「どんな音か/どこから来たか/何を示しているか」という環境音・非言語音の理解も、ヒューマノイドにとって重要な知覚機能なのです。

音を理解するための“要素構成”

では、音(声/環境音)をヒューマノイドが理解するためには、どんな要素・構成が必要なのでしょうか。次のような段階をイメージできます:

- 音のデータベースと関連づけられた情報

音声・音響イベントに関するデータベースがあります。例えば「犬の鳴き声」「お湯が沸く音」「車のクラクション」のように、音響信号と、それが何を意味するか(=音源・状況・意味)とを関連づけた情報が蓄えられています。 - 入力音の取得・特徴抽出

ヒューマノイドはマイクやマイクアレイ(複数マイク配置)を使って、環境中の音を取得します。「どこから音が来ているか(音源の方向)」「視覚(カメラ)から得られる状況」「直前に起きた出来事との因果関係」なども併せて捉えます。音が重なっている状況(複数音が同時にある)でも、その中から意味を持つ音を抽出する必要があります。 - 音源・状況との照合・分析

得られた音・方向・視覚・直前の出来事情報をもとに、「この音は何か」「どこから来たのか」「どういう状況か」を、データベースとその時の条件と照らし合わせて分析します。つまり、音の“意味”を解釈して「お湯が沸いた音」「クラクション」「犬が吠えた」などと認識するのです。

このように、ただ「声を聞く」だけでなく、「環境音・音源方向・視覚・直前の出来事・因果関係」など複数モダリティ(聴覚/視覚/時間情報)を統合して、意味ある判断をするという構成が鍵となります。

では、上記の構成それぞれに対して、技術的なアプローチや実例を見ていきましょう。

音声とデータベースを関連づけるファイルシステム・構造について

まず、音声(音響イベント)とそれに関連する情報(音源・意味・状況)をデータベース化し、利用できるようにするファイルシステムや構造が必要です。

技術的アプローチ

- 音響イベントデータベースを作る:例えば “犬の鳴き声/ガラスが割れる音/クラクション”など、各音ごとにラベル(何の音か)、状況(室内/屋外/騒音下)、マイク配置や録音条件のメタデータを付与します。

- ファイルシステム/データ管理:音ファイル(wav, flac 等)+ラベル+メタデータ(録音日時、マイク位置、距離、音源方向、状況説明)を関連づけて格納。アクセス性・検索性を考慮して、例えば SQLite/PostgreSQL+ファイルパス、あるいは専用音響管理システムを用いることがあります。

- 検索・マッチング機構:入力音の特徴を抽出(例えばメルスペクトログラム、MFCC、スペクトル特徴)して、データベースの既知音と比較する検索インデックスを作成します。

- ノイズ・環境変化対応:録音条件が変わっても、ラベル付けされた音イベントを汎用的に認識できるよう、データベースには複数条件(距離・方角・騒音レベル)でのサンプルを入れておくことが望ましいです。

研究・論文の紹介

- Causal inference in environmental sound recognition(Traer et al., 2021)は「私たちが環境音を認識する時、音源強度などの物理変数を推定しているか」を検証しています。

- また、音響イベントをヒューマノイドロボットが認識する研究として、 Sound Recognition with a Humanoid Robot for a Quiz Game(Tutul et al., 2023)があります。

この研究では、ロボットが「視界に入っていない音も認識できる」“音認識能力”を教育用ヒューマノイドロボットに持たせた実験が報告されています。

実現できるプログラムやサービス

- 音響イベント認識ライブラリ:例えば「Sound Event Detection (SED)」を目的としたライブラリ(PyTorch/TensorFlowベース)を利用すれば、既知の音ラベルに対して学習・推論が可能です。

- データベース構築用ツール:例えば Audacity 等で音録音・ラベル付け・メタデータ管理を行い、Python+SQLiteで管理する。

- 商用サービス:クラウド音響分析サービス(AWS Transcribe + Amazon Lookout for Vision のような形式で、音響イベントをクラウドで分析)や、Google Cloud Speech + 音イベントAPI(音声だけでなく音響イベントも分類できる)などがあります。

視覚情報と聴覚情報、直前に起きたこととの“因果関係”を見つける方法

次に、音をただ聞くだけでなく「見える情報(カメラ)」「直前に起きた出来事」「音と視覚との時間的・空間的ずれ」などを手掛かりに、音の意味を掴む方法をみていきます。

技術的アプローチ

- マルチモーダル統合:視覚(カメラ映像)+聴覚(マイク)を同時に取得し、どの視覚対象が音を出しているか、あるいは視覚対象の変化(例:水が沸く泡の上昇/車が近づく)と音の発生との時間差を見て「これが原因/音源だ」と推定します。

- 音源方向推定・定位:マイクアレイを使って音がどの方向から来たかを推定。視覚で検出された対象(例えば車/動物)との方向一致を見ることで、音と視覚対象との紐付けが可能です。

- 因果推論モデル:音と視覚・時間変化の因果関係をモデル化します。例えば、「カップから湯気が上がった →お湯が沸いた音」「車のブレーキランプが点いた→クラクション音」など、“直前+音”のパターンを学習します。ヒトの脳でも音と視覚刺激が「共通原因から発生したか」を推定する研究があります。

- 同期・時差処理:視覚刺激と聴覚刺激には往々にして時間差があります(光の速度/音の速度、処理遅延など)。“どれだけのずれなら同一事象か”を判断するモデルもあります。例えば、 Audio‑Visual Causality and Stimulus Reliability Affect Audio‑Visual Synchrony Perception(Li et al., 2021)では、音と視覚の同期知覚が「因果関係の強さ」や「刺激の信頼性」によって変わると報告されています。

研究・論文の紹介

- 音+視覚の因果関係・同期モデル:上述の Li et al., 2021。

- また、ヒューマノイドロボットにおける“音源方向に向きを変えて聞く”というアプローチを示した研究: Improving Humanoid Robot Speech Recognition with Embodied Sound Source Localisation(Dávila‐Chacón et al., 2014)では、ロボットがマイクアレイとスパイキングニューラルネットワーク(生物模倣)を使って音源方向を推定し、そこで音声認識性能を改善したと報告されています。

- さらに、最新では音声+視覚+因果処理を考慮したマルチモーダルモデルとして、 Human‑Inspired Computing for Robust and Efficient Audio‑Visual Speech Recognition(Liu et al., 2024) が「因果処理」「スパイク活動」「マルチモーダル統合」をキーワードに提示しています。

実現できるプログラムやサービス

- マルチモーダルAIフレームワーク:例えば、TensorFlow や PyTorch で音声+映像データを入力として扱い、「音が出た対象を視覚で検出」→「音源として紐付け」→「意味を判断」というモデルを作れます。

- 音源定位ライブラリ/API:例えば “Aurora 多マイク音源定位ライブラリ”や “Google Cloud AI Video Intelligence+Audio event detection”など、音と映像の同期・位置推定をサポートするサービスが存在します。

- ロボットプラットフォーム適用例:ヒューマノイドロボット(研究機体)において、マイクアレイ+カメラ+ロボット統合API(例:ROS (Robot Operating System) + Open3D/OpenCV)で、マルチモーダル知覚を実装している事例があります。

“音が何によって引き起こされたのか”を判断するシステム

最後に、音が「何によって引き起こされたのか」を判断するシステムの技術について整理します。つまり、「音=出来事の結果」であり、ロボットがそれを推定できるようにするというステップです。

技術的アプローチ

- 音響シーン解析 (Acoustic Scene Analysis):音がどのような物理的な出来事(例:物体衝突/機械作動/動物の鳴き声)から発せられたかを解析する技術。音の時間変化・スペクトルパターン・反響・マイク配置から“何が起きたか”を分類します。

- 因果インファレンス (Causal Inference):音源の物理的特性(強度、距離、環境反響)を推定し、「この音は近くの車がクラクションを鳴らしたから発生した」といった因果を判断する手法。上述 Traer et al. の研究では、「環境音認識には音源強度という物理変数を推定することが関わる」と示されています。

- 機械学習/深層学習モデル:音響イベント+視覚+時間変化を入力とし、「音の原因(例:犬/車/水沸騰)」を分類するモデル。特に背景雑音や混合音源がある複雑環境下でも耐えられるような設計が研究されています。

- ロボット応用:ヒューマノイドロボットにおいて、このような「音の原因推定」能力を搭載することで、視界に入っていない音源への反応(例:部屋の向こうで何かが起きた音)や、人間の声以外の音に対して適切な反応をすることが可能になります。上述の Tutul et al. の研究では、教育用ヒューマノイドが“音認識”を通じて参加者の活動をより豊かにできるという報告があります。

実現できるプログラムやサービス

- 音響イベント原因推定API:例えば、クラウドサービスに音を送信し、「この音は犬の鳴き声と思われます」「クラクションの可能性が高いです」と返す音イベント分類サービス。

- ロボットミドルウェアでの音‐原因推定モジュール:ROS環境下で、マイクアレイ+カメラ+因果推定ライブラリを統合し、「音発生→方向特定→視覚対象検出→原因推定」というワークフローを構築可能。

- 教育/介護ロボットでの活用:例えば「転倒音を検出し、転倒原因を推定して介助者を呼ぶ」「キッチンでお湯が沸く音を検出し、ロボットが“お茶をどうしますか?”と提案する」などのサービス実装が考えられます。

全体のまとめ

今回は、人の声だけでなく環境音・非言語音までをヒューマノイドが捉え、理解し、反応するための「音声/音響イベント理解」の構成と技術を、初心者向けに整理しました。

- マイクから入手した音声データを分析する基盤が第一歩。

- 次に、「人間の声指示」「騒音や背景音」「お湯が沸く音・鳥の鳴き声・クラクション」などの非言語・環境音も認識できることがヒューマノイドにとって必要。

- そのためには音のデータベース/マイク入力+特徴抽出/音源方向・視覚・直前出来事との統合という流れが鍵。

- 各ステップには、音声–データベース関連づけ、マルチモーダル統合/視覚情報との因果関係、音の原因推定という技術的アプローチがあります。そしてそれらを支える様々な研究・論文があります。

- 最後に、音が何によって引き起こされたかを判断するためには音響シーン解析・因果推論・機械学習モデル・ロボットへの応用という観点が重要です。

- 現在は、音響イベント認識ライブラリ・クラウドサービス・ロボットミドルウェアといった実装も進んでおり、ヒューマノイドが「耳を持つ」だけでなく「意味を持って音を聞く」段階に近づいています。

コメント